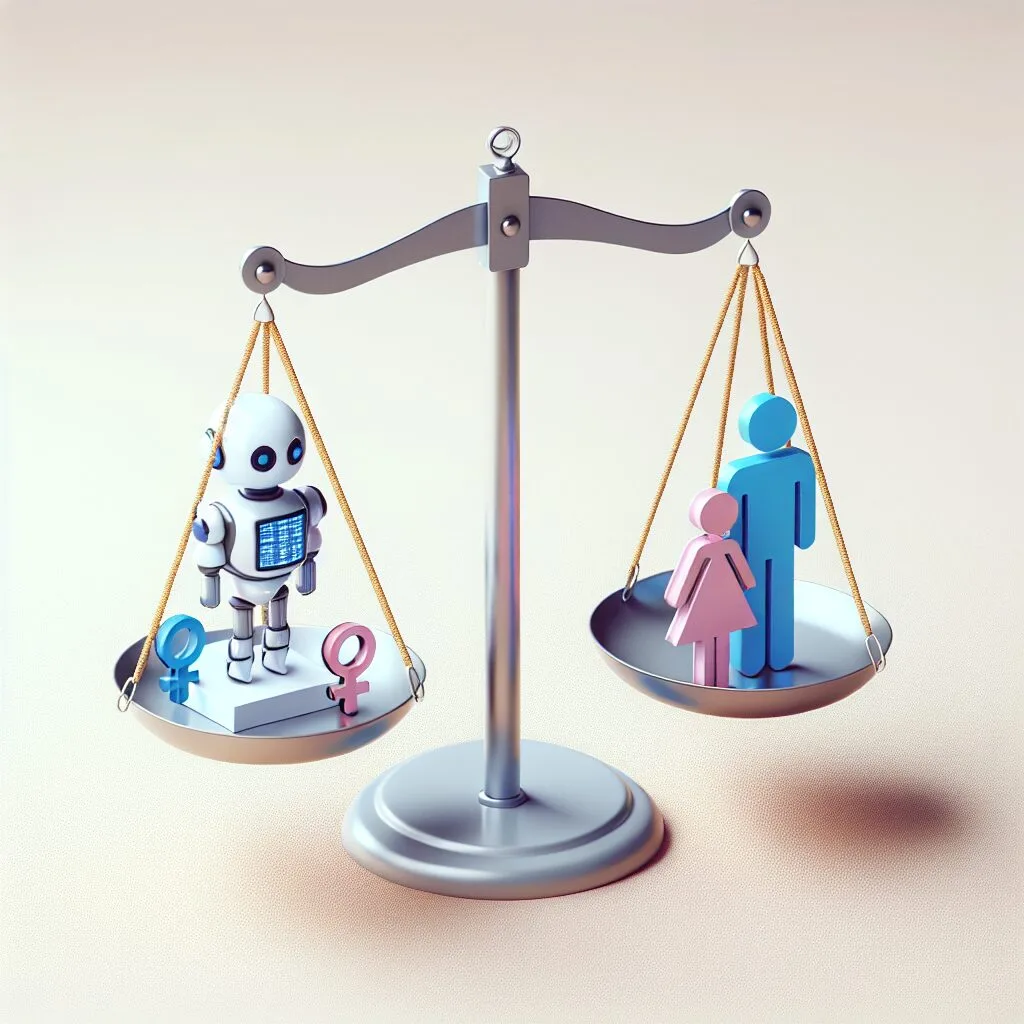

人工智慧中的性別歧視:我們需要了解什麼?

在當今科技快速發展的時代,人工智慧(AI)正逐漸融入我們的生活。然而,隨著這些技術的進步,我們也開始意識到AI系統中的潛在偏見,特別是性別歧視。這篇文章將探討AI中的性別歧視問題,並提供一些靈活的解決方案,以幫助開發者和使用者更好地理解和應對這一挑戰。

性別歧視是如何在AI中出現的?

AI系統的學習基於大量的數據。如果這些數據本身就存在性別歧視的偏見,那麼AI在訓練過程中也會學習到這些偏見。舉例來說,如果一個AI系統是針對招聘流程而訓練的,而所用數據主要來自過去的招聘紀錄,而這些紀錄可能已經反映了男女在職場上的不平等待遇,那麼該系統無疑會重複這些不平等。

數據偏見的影響

根據調查,許多AI模型在解讀性別相關數據時,確實存在顯著的偏見。例如,圖像識別技術在識別女性的相關標籤時,往往會出現錯誤或不平等的識別結果。這不僅影響了技術的準確性,更可能對女性的職業生涯和機會產生負面影響。

如何識別與應對AI中的性別歧視?

作為開發者和使用者,我們有責任確保AI技術的公平性。这需要一系列的步驟來檢查和減少潛在的偏見。

1. 評估和篩選數據

在開發AI模型之前,必須仔細評估所用數據的性質。這包括考慮數據集的來源、結構以及可能存在的偏見。進行數據篩選可以有效減少訓練過程中的歧視問題。

2. 使用公平性指標

監控和評估模型的公平性是非常重要的。利用公平性指標,可以幫助開發者識別和量化模型的性別偏見。這樣可以在設計階段就對偏見進行處理。

3. 用戶反饋

用戶的反饋對於改善AI系統至關重要。建立一個有效的反饋機制,讓用戶能夠報告他們遇到的問題,將有助於及時調整和修正模型中的偏見。

結論

儘管我們無法完全消除AI中的性別歧視,但通過積極的措施和方法,我們可以將其影響降至最低。通過提升數據管理的質量、應用公平性指標以及重視用戶反饋,AI系統的開發者可以創建出更公平、更可靠的技術,從而真正促進平等。